En numerosas ocasiones, los webmasters de un sitio web se obsesionan con indexar el máximo número de URLs en Google. La creencia que el número por delante de la calidad ha llevado a intentar indexar cuánto más mejor.

Sin embargo, en numerosas ocasiones, es preciso que te centres en indexar aquellas URLs que realmente se le puede sacar un partido al sitio web. Por ejemplo, si no te interesa indexar la página de política de privacidad y no le pusiste desde un principio el “noindex”, seguramente la tendrás indexada y aparecerá en los resultados de Google. Para eliminarla tendrás que realizar todo el proceso que vamos a describir a continuación.

Por lo tanto, conocer el procedimiento para eliminar una URL de Google es especialmente útil en muchos casos.

[bctt tweet=”La importancia de sacarse de encima aquellas URL que puedan penalizarte”]

¿Por qué eliminar una página del índice de Google?

Si has llegado a este punto seguramente es porque estás iniciándote en el mundo del posicionamiento, tienes un blog o bien directamente eres una persona que tiene una tienda online y te ha sugerido tu cuñado que para optimizar los resultados de búsqueda tienes que eliminar todas esas urls que dan error o que no merecen la pena.

Que no cunda el pánico, son cosas que pasan! Uno encarga su web al webmaster de turno y como ya hemos dicho en este blog, los diseñadores web son eso, diseñadores… Al final acaba indexada hasta la entrada de blog de ejemplo de “hello world” que ni han borrado ???? ¿Por qué van a tener que saber optimizar una web? Que va! Eso ya te apañarás tu luego!

Aquí en nuestra agencia si nos preocupamos de todos los detalles (web & seo), pero no todo el mundo es así por desgracia.

Puede ser también que tu web la hayan diseñado y optimizado perfectamente, pero por cualquier motivo posteriormente has eliminado alguna página de tu sitio web. Esta práctica es algo común en los usuarios que no saben la repercusión negativa que puede traer esta acción si no terminamos el proceso correctamente.

Nos referimos a terminar el proceso correctamente a que si eliminamos una página o post de nuestra web, esas páginas estaban seguramente indexadas en los resultados Google, y al borrarlas lógicamente ya no pueden mostrarse.

Las URL eliminadas seguirán apareciendo en los buscadores, pero una vez el usuario haga click le llevará a un error 404. Este tipo de páginas crean pánico en la mayoría de webmasters. Consideran que el sitio web da mala imagen y, que por ende, el usuario lo abandonará de forma instantánea. No te alarmes. Cabe recalcar que es posible sacarle partido a este tipo de páginas.

El objetivo es intentar atraer al usuario a través de un buen trabajo de marca. Ser creativos, utilizar un buscador y realizar trabajo de branding puede provocar que el usuario siga en el sitio web.

► No hay que obviar que los errores 404 siguen siendo parte de un sitio web. Que aparezcan en demasía pueden acabar penalizando a la página, pero mensajes creativos e incitar al usuario a seguir buscando en el sitio, aquello que necesita puede acabar siendo positivo.

Además de este tipo de páginas, es necesario eliminar URL por muchos otros motivos. En algunos casos, se produce un cambio de plataforma de gestión de contenidos y es necesario redireccionar todo el contenido. En caso de que el posicionamiento no esté funcionando como debería es una buena oportunidad para empezar de cero.

Además, los virus informáticos y los ataques a servidores están a la orden del día. Puede provocar que Google lea los contenidos como si fueran de baja calidad. Es infinitamente necesario eliminar contenido obsoleto y que está penalizando al sitio web.

La URL y la utilización de las palabras claves son especialmente importantes para posicionar los contenidos. Por prisas y falta de atención, pueden haberse producido errores.

Proceso para eliminar las páginas indexadas por Google utilizando Google Search Console

Dejémonos de rollos, ¡vamos al grano!

1. Lo primero que haremos será un trabajo de investigación para ver cuantas urls tenemos indexadas. Para ello ejecutamos en el buscador un comando “site:” seguido de nuestro dominio, y hacemos click en buscar para que nos muestre los resultados. Ejemplo:

Nos devolverá una lista con todas las páginas indexadas de nuestra web. Si tienes muchas urls indexadas, es posible que te preguntes cómo extraer el listado de forma automática, ¿sería muy bueno poder hacerlo verdad?

Bien, aquí tienes un truquito: Serp scraper

Descarga el programa. Una vez lo tengas ejecútalo, selecciona tu versión de Google en “country”, en nuestro caso “google.es”. Selecciona el número de resultados que quieres que te muestre y el número de páginas. Seleccionamos también si queremos un retardo en el rastreo en la opción “delay”. En el cuadro de “search queries” insertamos el mismo comando site con el dominio tal cual lo hicimos en Google anteriormente, hacemos click en scrape y listo!

Se nos descargará un fichero en formato .csv que podremos abrir con Excel o similar. Seguramente tendrá las columnas desordenadas, por lo que tendremos que seleccionar la primera columna completa, pinchar en datos > ordenar y delimitar las columnas por comas para que se vean correctamente.

En el caso de que tu web tenga pocos resultados, quizá no sea necesario bajarse el programa Serp Scraper y proceder a realizar la selección de las páginas manualmente.

Si por el contrario, lo que tienes es un blog o tienda online de gran volumen, lo que te vendría mejor es usar Screaming frog o Deepcrawl en los que poder sacar todo el volumen de urls. Cabe destacar que existe una nueva herramienta llamada Seomator la cual he probado y es increíble!

El trabajo a realizar en este caso sería copiar todas las urls que no nos interese tener indexadas, y posteriormente las pegaremos en search console (lo veremos a continuación).

Con esta limpieza de urls conseguiremos que Google vaya directamente a las páginas que te importan, no dejándole que pierda el tiempo en páginas “basura”.

Algunos ejemplos de páginas que tendrían que desindexarse serían: categorías y páginas sin contenido y páginas de aviso legal y cookies con el 90% de la misma copiado de otra web.

2. Si ya tenemos el listado de urls que no nos interesan y que queremos desindexar, el siguiente paso es darte de alta en Google Search Console , vinculando tu cuenta de Google (Gmail) con esta herramienta conocida anteriormente como Webmaster Tools.

Una vez nos hemos dado de alta, procedemos a agregar la página web en cuestión de la que somos dueños o hemos realizado. Nos pedirá que tenemos que verificar la propiedad. Elegimos uno de los métodos disponibles que queramos o nos vaya a ser más fácil.

En nuestro caso, solemos bajar el archivo HTML de verificación, el cual debemos subirlo a la raíz del servidor (bien vía Cpanel en el administrador de archivos o vía Ftp). Una vez subido hacemos clic en verificar y si todo está correcto nos aparecerá el tic verde.

Nos aparecerá un panel de control con nuestra propiedad/es verificada/s:

3. Entramos en la propiedad o sitio web que hemos dado de alta. En la izquierda te aparecerá un menú con diversas opciones: apariencia en el buscador, tráfico de búsqueda, índice de Google y rastreo.

Como te estarás dando cuenta, estás ante una herramienta super importante, con la que puedes conocer tanto los links que apuntan a tu sitio como las palabras clave por las que están encontrando tu web. En definitiva, una gozada!

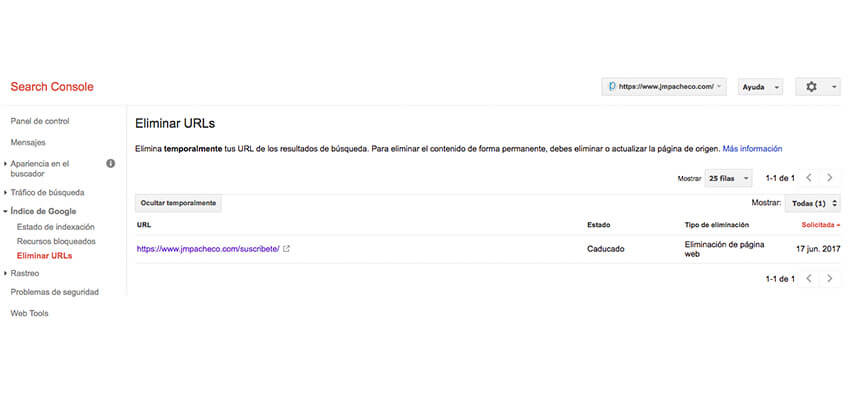

Bien, en este caso el procedimiento para eliminar páginas indexadas por Google se realiza a través de: Índice de Google > Eliminar URLs.

Pinchamos en “Ocultar temporalmente” e introducimos la url entera que queramos desindexar.

Nos aparecerá una nueva página en la que tenemos que indicar el tipo de solicitud. Aquí seleccionaremos “ocultar temporalmente la página de los resultados de búsqueda y eliminarla de la caché”.

Este proceso lo haremos manualmente, introduciendo una por una cada url que queremos desindexar.

4. Hecho esto, el panel de “Eliminar URLs” nos mostrará las url que hemos solicitado su eliminación y una columna de estado en el que indicará si están pendientes, eliminadas o caducadas.

Con esto, se consigue que dicha URL no aparezca indexada en Google durante los próximos tres meses, aproximadamente. Si acabas el procedimiento en este punto, al cabo de 90 días, la página volverá a indexarse.

Puede pasar que las urls caduquen y se vuelvan a indexar, ya que esto es una eliminación temporal, por ello si queremos que no aparezcan más, para evitar futuras indexaciones no deseadas, una vez hecho este proceso de eliminación temporal en search console, debemos comprobar que dichas páginas están marcadas como “noindex”. En el caso de tener WordPress + SEO Yoast, lo veremos e indicaremos aquí:

Meta robots > Cambiar a noindex

Salvo excepciones, Google tarda entre tres y 24 horas en eliminar el contenido indexado. Por ello, si tenemos la página con el “noindex” , lo que pasará es que una vez se elimine la página de los resultados de Google, esta no volverá a indexarse.

Esta es la forma de eliminar una a una las url, pero seguramente si tienes muchas que desindexar te preguntarás…

¿Cómo eliminar un montón de urls de forma masiva?

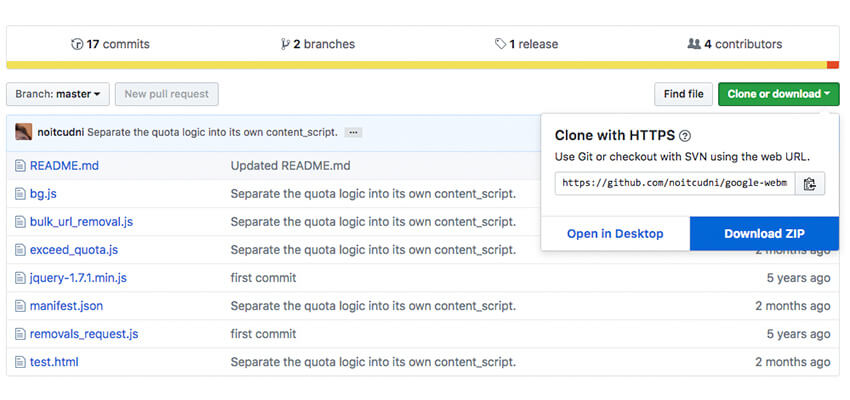

Existe una herramienta que ha venido a salvarnos para poder eliminar de forma rápida y efectiva: Google Webmaster Tools Bulk Url Removal.

El primer paso es descargar la herramienta en este enlace.

Haz clic en download y luego en download zip.

Una vez tengas el archivo descargado, descomprímelo.

El próximo paso es dirigirte a la parte derecha de tu navegador Google Chrome, hacer clic en el icono de los “3 puntitos” para que se despliegue el menú. Luego hacer clic en “más herramientas” y después en “extensiones”.

Se nos abrirá una ventana con todas las extensiones que tienes instaladas. En la esquina superior derecha tendrás que marcar la opción de “modo de desarrollador”. Hecho esto se te habilitará un menú con la próxima opción que tendrás que hacer clic: “cargar descomprimida”. Aquí es donde tendrás que arrastrar o seleccionar la carpeta para cargar el archivo de la extensión que ya tenemos descomprimido.

Una vez hecho esto, se te instalará esta extensión, que hará que tu Search Console ahora tenga superpoderes 😉

Ahora verás una nueva opción que te permitirá subir un archivo.

Podrás cargar un archivo que deberás generar en formato .txt (con bloc de notas, sublime text o similares), en donde deberás incluir las urls por líneas separadas (no permite subir más de 1000 urls por archivo).

Cuando subes el fichero observarás que sube tramos de 25 en 25. En caso de que te aparezca un error de “exceeded limit”, tendrás que pulsar F5 o refrescar para que el proceso continue.

ACTUALIZACIÓN: Tras el nuevo Search Console, han actualizado la extensión, aunque esta vez no es gratis: https://chrome.google.com/webstore/detail/webmaster-tools-bulk-url/pmnpibilljafelnghknefahibdnfeece

¿Cómo encontrar los errores 404?

A través de Google Search Console se pueden ver en: Rastreo > Errores de rastreo.

También podemos utilizar la herramienta Broken Link Checker , o la mencionada anteriormente: Screaming frog.

Una vez tengamos el listado con todos los errores, se procedería a la eliminación en search console, realizado el proceso mencionado en los pasos anteriores.

Después lo recomendado sería realizar las redirecciones correspondientes. Por ejemplo, si tenemos un error 404 en una página que ya no existe pero tenemos una página similar en la que puede encajar con el resultado de búsqueda, se realizaría una redirección de una a otra, así se corregirían dichos errores.

Bloquear las URLs mediante Robots.txt

Una orden segura y que nunca fallará es bloquear directamente las urls a través del fichero robots.txt. Este archivo se encuentra en la raíz de nuestro directorio. Podemos entrar a través del hosting > Cpanel > Administrador de archivos o bien vía Ftp (lo que nos sea más cómodo).

¡Ojo! Este proceso se realizaría en el caso de que ya tengamos eliminadas las urls en search console y comprobado que se han desindexado totalmente y queramos asegurarnos de que no se van a indexar más, o mejor dicho que queremos que el robot de Google no pierda ni un segundo de tiempo en pasar por ellas y detectar que dichas páginas están en “noindex”. Esta orden se lee primero de todo y va a misa! Esto se hace así porque si bloqueamos por robots.txt antes de que Google desindexe las páginas, pues lógicamente no va a poder entrar para desindexarlas.

Localizamos dicho archivo y le introducimos las urls que no queremos que pase el robot de Google. Este proceso se hace con el atributo “Disallow”. Aquí mostramos un ejemplo de nuestro robots.txt. *

* Los asteriscos que verás en las líneas del robots.txt quieren decir que repercuta en todo lo que va después o antes (según al posición del asterisco).

¿Cómo eliminar “error reading url”?

Que Google lea correctamente las URLs, y que estas tengan las palabras clave adecuadas, es imprescindible para asegurar un SEO correcto y que el sitio web tenga posibilidades de conseguir un buen tráfico orgánico.

No obstante, la utilización de esta herramienta se reserva a fines de carácter urgente como la exposición de contenidos por error o que revelan datos confidenciales. Google es muy claro al señalar que usarla con otros fines puede acabar penalizando y provocando incidencias en el propio sitio web.

La importancia de eliminar páginas indexadas por Google

En el caso de ser atacado por un pirata informático se deben eliminar las URL hackeadas, como se ha mencionado anteriormente. En ninguno de los casos, eliminar el sitio web por completo. Eliminar contenido duplicado en diferentes URLs o empezar desde cero en un sitio web después de adquirir el dominio de otra persona tienen otros procedimientos.

► La importancia de eliminar una URL de Google que pueda penalizar al sitio web tiene una importancia capital.

¿Quieres conseguir el máximo número de visitas en tu página? Debes mostrar tu mejor apariencia al buscador.

Saca provecho de los errores 404 de forma creativa para captar la atención del usuario y quédate con aquellas URL que te aportan beneficios. Recuerda, la calidad por delante de la cantidad.

Déjanos tu comentario si te ha servido este post de ayuda.

Especialista en WordPress y Posicionamiento SEO. The boss en JmPacheco.com & Diseñador Web & SEO en Informatix.es. Me encantan los negocios online, ya que me permiten vivir el estilo de vida que quiero.

¿TE HA GUSTADO EL POST? TU OPINIÓN ES IMPORTANTE

Aún no te vayas, queremos pedirte un favorcillo 🙂 ¿Puedes ayudarnos a compartir esta página en tus redes sociales? Así podremos llegar a más gente como tú que necesita nuestra ayuda en temas como este. Tan sólo tienes que hacer click en los botones de aquí abajo. ¡¡Mil gracias de verdad!!

(7 votos, promedio: 4,29 de 5)

(7 votos, promedio: 4,29 de 5)

Buenas noches, muy buen artículo!

Estoy intentando instalar la extensión para eliminar de manera masiva pero la carpeta no me la acepta en las extensiones de Google porque dice que no tiene el manifiesto.

¿Alguna forma de solucionar este problema?

¡Saludos!

Hola Tomás, muchas gracias!!

La extensión dejó de funcionar tras la actualización de Search Console, pero por lo visto la han actualizado para este, aunque yo aún no la he probado.

Tiene un coste de 10,99€ : https://chrome.google.com/webstore/detail/webmaster-tools-bulk-url/pmnpibilljafelnghknefahibdnfeece

También dicen que si la instalas y al subir el CSV no pasa nada, que refresques la página y ya funciona.

Ya me dices si la pruebas ;))

Saludos!!

Buenos tardes José Manuel,

Gracias por el post, me ha resultado muy interesante.

Quería hacerte una pregunta a ver si puedes ayudarme. Necesito borrar una url que actualmente me tiene indexada Google, borrarla para siempre. Lo que pretendo hacer es desindexar dicha url usando la opción de Retirada de URLs de la nueva GSC y luego sencillamente borrar la página. Asumo que no es necesario marcar nada en el fichero robots si he eliminado la url. ¿Estoy en lo correcto?, ¿Estaría haciendo algo mal?.

Muchas gracias por tu ayuda.

Jesús

Hola Jesús!!

Me alegro muchísimo que te haya resultado interesante y de ayuda el post!

Estas en lo correcto, desindexar la URL con “retirada de URLs”. No hagas nada en robots, sobretodo antes, ya que si la bloqueas por robots, Google no podrá desindexarla de las SERPs.

Saludos!!

Información muy clara y bien explicada sobre posicionamiento web, gracias

Muchas gracias a ti Makrodownload por tu valoración!

He cambiado el diseño de mi página web por completo y los artículos los cree con el mismo nombre que tenían anteriormente y a las páginas obsoletas le hice redirección 301, pero en el nuevo search console he leído que ya aparece un apartado para eliminar páginas de la serps, (retirar urls) pero en mi caso aún no me aparece. Existe alguna forma de solicitarlo o toca esperar a que google lo habilite supongo. Sería una herramienta imprescindible para desindexar páginas que ya no existen y no queremos que google rastree.

Hola Alejandro, muchas gracias por tu respuesta!

En el nuevo Search Console aparece una opción a simple vista “Retirada de URLs”. Ahí es donde tienes que introducir las urls que quieras eliminar de las SERP, y como ya sabrás si eres SEO, metiendo la etiqueta “noindex” a dichas páginas, para que no se vuelvan a indexar nunca más.

Saludos!!

Hola,

Recién he indexado mi pagina web con google, y en el buscador de google aparecen demasiadas URLS, y lo que me llamó la atención fue que había productos dentro del buscador. Mi pregunta seria de que forma puedo manejar que producto se puede ver y cual no (debido a que puede que ese articulo ya no exista) para yo tener un mejor control.

Hola Andrés, muchas gracias por tu comentario.

Sobre tu pregunta, en los ajustes de cualquier plugin SEO que utilices viene la opción para por defecto desindexar los productos (si es que así lo quieres). Por ejemplo, si tienes Yoast, tendrías que dirigirte hacia la sección de “apariencia en el buscador”, y en productos marcar para que no aparezcan en los resultados de búsqueda. Así por defecto los productos se quedan en noindex. Si luego quisieras indexar algún producto, tendrías que entrar en la ficha de dicho producto y abajo en la caja de yoast indicar que quieres que se indexe.

Espero que te haya servido de ayuda. Saludos!!

Hola, muy buen post!

Tengo una duda y es como eliminar las url con el nuevo Search Console, si se puede?, o se puede acceder de alguna manera al anterior Search Console.

O si hay alguna otra manera de eliminar ahora con el nuevo SC o alguna otra sugerencia?

Saludos

Hola Mar, muchas gracias por tu opinión!!

Si estás en el nuevo SC, hay una opción abajo del todo a la izquierda que dice “ir a la versión anterior” y así vuelves al antiguo SC.

Para eliminar las url yo sigo haciéndolo con el antiguo SC y creo que en el nuevo aún no está la función. En el nuevo sí que tienes para enviar la url a Google pero no para eliminar (que me corrija alguien si no es así).

Saludos!!

Hola JM, gracias por la respuesta, si así lo hacia antes, buscar ahí abajo e ir al viejo SC, pero es que ahora no aparece tampoco. Alguna otra sugerencia para poder solicitar desindexar a través de Search Console.

Y en el caso que no se pueda, como hacer para quitar una url o desindexar?, hay alguna otra manera?

Otro camino, Si hago un 301 de esa url que quiero quitar a una URL existente, sería suficiente?, redirigiría a la existente, pero sigue quedando la anterior?

Gracias

Hola Mar,

La opción de desindexar en el antiguo SC debe de salirte. Yo trabajo a diario con esta opción y se que existe y funciona, por eso intenta de nuevo porque debe aparecerte.

Sobre la 301, habría que analizar si hacer una redirección es buena solución: autoridad de la url de origen, misma temática, etc. Lo mejor es que si la url que quieres desindexar, no tiene tráfico, la desindexes.

Gracias a ti ;))

Hola Jose. Tngo la misma duda que Mar y al día de hoy, 6/06/19 ya no sale el antiguo SC. ¿Alguna otra sugerencia?

El artículo muy interesante y muy fácil de seguir. Muchas gracias.

Hola Ana, muchísimas gracias!!

En el antiguo SC debe salirte como le comenté a Mar. A día de hoy sigue apareciendo la opción en: Índice de Google > Eliminar URLS.

Saludos!!

Hola José! un artículo de lujo la verdad, muchas gracias.

Te cuento una duda que tengo:

Estoy haciendo una migración de Drupal a WordPress, y tengo más de 2000 urls que quiero que desaparezcan (la mayoría indexadas, otras no). ¿Me recomiendas hacerlo por Search Console?

Había pensado hacer redirecciones 410, pero no puedo dejar 2000 líneas de código en el .htaccess.

Seguro tu experiencia me servirá de mucho, gracias de antemano.

¡Un fuerte abrazo!

Pablo

Hola Pablo, muchísimas gracias!! 😀

Sobre tu duda, en este caso yo pienso que lo mejor es hacer una desindexación masiva poco a poco, ya que como tu dices, 2000 redirecciones en el .htaccess son bastantes redirecciones.

Ya nos contarás que tal te ha ido.

¡Un abrazo!

Hola, comencé a crear una web en wordpress con un tema. Después cambié de tema y también las url’s de cada página. He sguido tus indicaciones para eliminar la indexación de las páginas antiguas.

El caso es que las paginas antiguas en worpress ya las he borrado y no puedo entrar en ellas para aplicar el “nofollow”. Cómo lo puedo solucionar?

Saludos,

Hola Oriol!

Pues el caso que comentas sería mejor analizarlo para poder sacar conclusiones. Necesitaría la url.

Aún así en tu caso lo que a priori se me ocurre es hacer si ya has borrado las páginas, sería hacer redirecciones de las urls antiguas a las nuevas.

Saludos!!

Excelente post ! Les dejo aquí un video tutorial que hice sobre como ELIMINAR URLs en FORMA MASIVA ! https://www.youtube.com/watch?v=R0E_D3X-eOA

Espero les sirva !

Muchas gracias Diego!!

Un saludo!!

Hola! excelente explicación, me fue de muchísima ayuda para eliminar masivamente urls. Gracias por el aporte!!!!!

Tengo una consulta: Cambie la ruta de urls en mi tienda, por lo cual estoy llena de errores 404. ¿Qué es mejor?

-Opción 1 : eliminar TODAS las url y comenzar con el posicionamiento de las nuevas desde 0 sin tener redireccionamientos 301.

-Opción 2: dejar las principales categorías con redireccionamientos 301 para que no pierdan su posicionamiento y sólo eliminar las url de subcategorias y productos?

Gracias nuevamente!!

Hola Carolina, muchísimas gracias!

En cuanto a tu problema, sería cuestión de ver el proyecto detenidamente para sacar conclusiones.

Pero si es cierto que si tienes categorías bien posicionadas, es mejor que hagas redirección a la nueva url de categoría.

Te escribo por privado y lo vemos 😉

La mejor explicación que he encontrado respecto a este método, muchas gracias.

Muchísimas gracias Luis!!

Me alegro mucho que te haya sido clara la explicación y te haya servido.

Un saludo! 😀

Buenas tardes,

en primer lugar agradecerte este post tan interesante. Yo creía que en SC se eliminaban las URLs para siempre y no volvían a aparecer, pero ya veo que a los 3 meses se vuelven a indexar.

Ahora me surge una duda:

Tengo una tienda hecha con Prestashop y me salen casi 5000 erorres de rastreo. Iban saliendo por decenas cada día y las iba metiendo masivamente en eliminar URL. Ahora al cabo de los años con la web tengo casi 5000.

El caso es que no sé como eliminar estos productos y categorías antiguas de forma permanente.

Se me ha ocurrido coger ese listado de 5000 URLs y dar “Disallow” en el Robot txt.

¿es una buena idea? ¿Cómo podría hacerlo?

Gracias de antemano.

Hola Pilar,

Muchísimas gracias, me alegra que te haya gustado y servido para algo este post 🙂

En cuanto a tu duda, para que dichas urls no se vuelvan a indexar tras eliminarlas en SC, lo que tienes que hacer es marcarlas como “noindex”, y así no volverían a indexarse tras eliminarlas.

Ya nos comentarás que tal te ha ido. Y si necesitas ayuda, aquí estamos.

Muchas gracias!!

Un saludo

¡Fenómeno José Manuel!

Muy buena explicación de cómo eliminar URLs. Sobre todo me gusta que aclaras el tema de cómo utilizar el bloqueo en Robots.txt. Si le decimos que no puede entrar, no puede ver el Noindex, por lo que ojito con hacer esto para intentar que no indexe páginas. Porque si no están eliminadas y las ha rastreado, va a volver a intentar rastrearlas y el bloqueo no solucionará nada. Las seguirá indexando. Y encima nos saltará un aviso de problemas en la cobertura de índice y desperdiciaremos presupuesto de rastreo en páginas que no se pueden rastrear. Así cuidado con esto. ¡Muy bien aclarado!

Un saludo

Muchísimas gracias por tu comentario Luis!! Y me alegra mucho verte por aquí (ya que yo también sigo tu blog), y que haya gustado cómo he aclarado este tema.

Un saludo!! 😀

Buenos días.

He puesto en práctica todo lo que he aprendido en esta entrada del blog en relación a la eliminación de URLs desde Search Console. La cosa es que tenía más de 1.000 errores 404 debido a un cambio en la estructura de la página (lo hice porque mejora la experiencia de compra y se ha posicionado muy pronto todo el contenido nuevo). He esperado a que Google indexara bien la nueva información y, como las URLs con errores no existen ni necesito redirecciones de ellas, las he querido hacer desaparecer… y ES AHÍ donde no sé muy bien si lo he hecho. Os pongo lo que me dice Google (en cada una de las URLs):

– URL

https://www.dominio.com/lo-que-sea/loquesea

– ESTADO

Eliminada

(da opción de volver a incluir)

– TIPO DE ELIMINACIÓN

Eliminación de página web

– SOLICITADA

1 de agosto

Esto me lo pone en todas las URLs que quise eliminar, las que estaban con 404. ¿Con esto ya es suficiente para que Google las elimine de su contenido indexado? Lo digo porque esta URL ya no va a aparecer en la web (web woocommerce), o es necesario hacer algo más… (lo digo porque no puedo marcar nofollow en algo que no existe en mi web).

¡Muchísimas gracias! 🙂

Hola de nuevo Alberto,

Pues te comento, si has eliminado las urls y las envias a eliminar en Search Console, pues se eliminarán y lógicamente no volverán a indexarse por que ya no existen.

El problema sería si las urls que eliminaste han sido enlazadas por ahí. Tendrías que detectar si tienes enlaces rotos. En ese caso si tendrías que revisarlos y hacer redirecciones para corregirlos.

Ya nos cuentas 😉

Casi 1000 errores 404 he generado en mi web debido a que he cambiado la estructura de la tienda porque creo que es mejor la nueva, y como dicen, si mejora la experiencia del usuario, hazlo.

Con esto, al modificar las URLs las nuevas se han indexado perfectamente, y ahora, es el momento de usar la eliminación masiva de URLs con el “remove pages from search results and caché” porque ya no existen y, por lo tanto, al estar las nuevas posicionadas, me viene fenomenal. ¡Muchas gracias por la ayuda!

Además, cuando termine de eliminar eso, voy a empezar con los “nofollow”, que siempre da algo de miedo, pero creo que mejorará mucho el esquema que Google muestra de mi tienda. La verdad, los resultados son buenos y no muestra nada de páginas, sino categorías de producto, pero aún así, haré limpieza.

Muchas gracias de nuevo. Un gran blog.

Mil gracias por tu comentario Alberto!

Es toda una satisfacción que esta información compartida, sea de ayuda y sea premiada con comentarios como el tuyo 😀

Te deseo mucha suerte con tu proceso. Cuando termines, si quieres puedes contarnos que tal resultados te ha dado.

Saludos!!

Es justo lo que estaba buscando, estoy calibrando un mini proyecto que estaba desastroso y con ajustes básicos de on page esta subiendo muy muy rápido. Gracias

Hay muchas 404 que no tienen enlaces desde nuestra web pero que aún siguen indexadas en google.

Se pueden pasar meses hasta que se borren definitivamente.

Muchísimas gracias Rafa! Me alegro que te haya ayudado este post 😉

Y efectivamente, hay urls que sucede lo que comentas por desgracia.

Un saludo!!

Gran post. Me va a ayudar bastante.

Te comento un poco mi caso a ver si me puedes echar una mano.

Resulta que tenía una carpeta llamada “lists” en la raiz de instalación la cual me generó un montón de .html y fueron indexadas por google.

El problema que tengo es que esa carpeta no existe ya porque tuve que levantar un backup y desapareció, sin embargo ahora tengo más de 100 urls indexadas y no sé que hacer para poder quitarlas.

He probado a eliminar url desde SC, pero vuelven a aparecer y no puedo poner noindex porque la carpeta ya no existe.

¿Qué me recomiendas hacer para poder quitar esas url definitivamente?

Las url generadas son del tipo: http://www.midominio.com/lists/admin/?page=logout&tk=59001bdd9cb y al entrar a ellas me aparecen un error 404.

Muchas gracias de antemano.

Hola Antonio! Nos alegra un montón que este artículo te sirva de ayuda! :))

En cuanto al caso que comentas, sería cuestión de ver el dominio de cerca. Si te parece envíanos el dominio por privado (email) si no quieres dejar tus datos por aquí.

Pero así sin verlo, lo primero que se ocurre es desindexar dichas urls en Search Console y si consiguen desaparecer de las SERP, justo en ese momento bloquearlas por robots.txt para que no vuelvan a indexarse.

Si se repite el patrón de urls y todas comienzan por /lists/, pues sería poner la siguiente línea en robots.txt: Disallow: /lists/*

Aun así, sería mejor ver tu caso detenidamente.

Gracias a ti por la respuesta. Un saludo!

Ten cuidado al manipular el robots.txt, si bloqueas antes una url por robots del noindex, no puede leer esa directiva a nivel de url, es decir, primero va leer como dices el robots.txt (aunque no es siempre a veces se salta el archivo por ejemplo de enlaces externos), si ve que X url (pongamos indexada) está bloqueada, es imposible que lea el meta-robots noindex (está contenido en el html de la url), por tanto si esa url X no recibe enlaces externos (ahi si leería directamente la url X y vería ya el meta noindex) nunca podrá ver la directiva y quedará indexada.

Aunque hago mención que también se pueden hacer noindex a nivel de robots.txt, sinceramente no lo utilizo ni lo he probado aun, y según tengo entendido hay opciones mejores, imagino que usar las meta y por eso es utilizado globalmente.

Saludos!

Muchas gracias por tu comentario Álvaro! Es cierto, quizás se me ha pasado detallar mejor lo que comentas. Como bien dices, el proceso del bloqueo en robots.txt siempre sería al final, cuando la url ya no está indexada.

Saludos!!